如何理解Normalization,Regularization 和 standardization?

May 16, 2017 · 1. normalization和standardization是差不多的,都是把数据进行前处理,从而使数值都落入到统一的数值范围,从而在建模过程中,各个特征量没差别对待。 normalization一 …

深度学习中 Batch Normalization为什么效果好? - 知乎

Group Normalization是Layer Normalization和Instance Normalization 的中间体, Group Normalization将channel方向分group,然后对每个Group内做归一化,算其均值与方差。 如 …

z-score 标准化(zero-mean normalization) - 知乎

最常见的标准化方法就是Z标准化,也是SPSS中最为常用的标准化方法,spss默认的标准化方法就是z-score标准化。 也叫标准差标准化,这种方法给予原始数据的均值(mean)和标准 …

如何理解归一化(Normalization)对于神经网络(深度学习)的帮 …

2018,Gradient Normalization(ICML) GradNorm Gradient Normalization for Adaptive Loss Balancing in Deep Multitask Networks ICML 2018. 2018,Kalman Normalization. Kalman …

CNN为什么要用BN, RNN为何要用layer Norm? - 知乎

Batch Normalization是针对于在mini-batch训练中的多个训练样本提出的,为了能在只有一个训练样本的情况下,也能进行Normalization,所以有了Layer Normalization。 Layer …

为什么Transformer要用LayerNorm? - 知乎

Batch Normalization(以下简称BN)的方法最早由Ioffe&Szegedy在2015年提出,主要用于解决在深度学习中产生的ICS(Internal Covariate Shift)的问题。若模型输入层数据分布发生变化, …

Weight Normalization 相比batch Normalization 有什么优点呢?

因此,Batch Normalization不适用于对噪声敏感的强化学习、生成模型(Generative model:GAN,VAE)使用。相反,Weight Normalization对通过标量g和向量v对权重W进行 …

Batch normalization和Instance normalization的对比? - 知乎

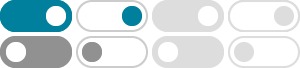

蓝色的方块是一起进行Normalization的部分。 由此就可以很清楚的看出,Batch Normalization是指6张图片中的每一张图片的同一个通道一起进行Normalization操作。而Instance Normalization …

标准化和归一化什么区别? - 知乎

缩放到0和1之间,保留原始数据的分布(Normalization——Normalizer()) 1就是常说的z-score归一化,2是min-max归一化。 举个例子来看看它们之间的区别,假设一个数据集包括「身高」 …

transformer 为什么使用 layer normalization,而不是其他的归一化 …

Normalization目的就是让分布稳定下来(降低各维度数据的方差)。 不同正则化方法的区别只是操作的信息维度不同,即选择损失信息的维度不同。